“Es culpa del algoritmo“. Acostúmbrese a esa frase pues la comenzará a escuchar con mayor recurrencia toda vez que día son más los procesos, los aspectos de su vida y las interacciones con entidades que son analizados por un algoritmo en vez de por una persona.

Sus aplicaciones a una universidad o a un trabajo, antes de llegar a mano de unos de los recruiters, pasan por un algoritmo que las barre, las analiza, las filtra y -una de dos- las selecciona o las rechaza para que luego un humano complete el proceso.

Su solicitud para un crédito o un seguro, pasa por un algoritmo que mide el riesgo que usted representa a partir de mucha más información que la que cualquier humano puede analizar. Información que sale de las fuentes tradicionales de información pero que cada vez se complementa más con datapoints de lo que llamamos nuestra identidad digital, esas huellas que dejamos cada vez que nos conectamos a Internet y utilizamos cualquier dispositivo tecnológico o servicio en línea.

El problema es que el algoritmo no es perfecto. Es más, está lejos de serlo.

Son varios los casos –documentados– en que una persona ha sido arrestada porque “el algoritmo” los ha identificado erróneamente.

Son decenas de miles de hojas de vida las que se han ido a la basura porque estaban escritas para ser leídas por un humano y no contenían las palabras claves que el algoritmo usó para rankearlas.

Son millones las aplicaciones descartadas y negadas porque el algoritmo encontró una correlación (que nadie sabe de donde salió) que afectó la calificación final de la persona.

Y ahora, son miles de estudiantes los que terminaron sin poder presentarse a una universidad porque un algoritmo decidió bajarles las notas por variables sobre las cuales no tienen ningún control.

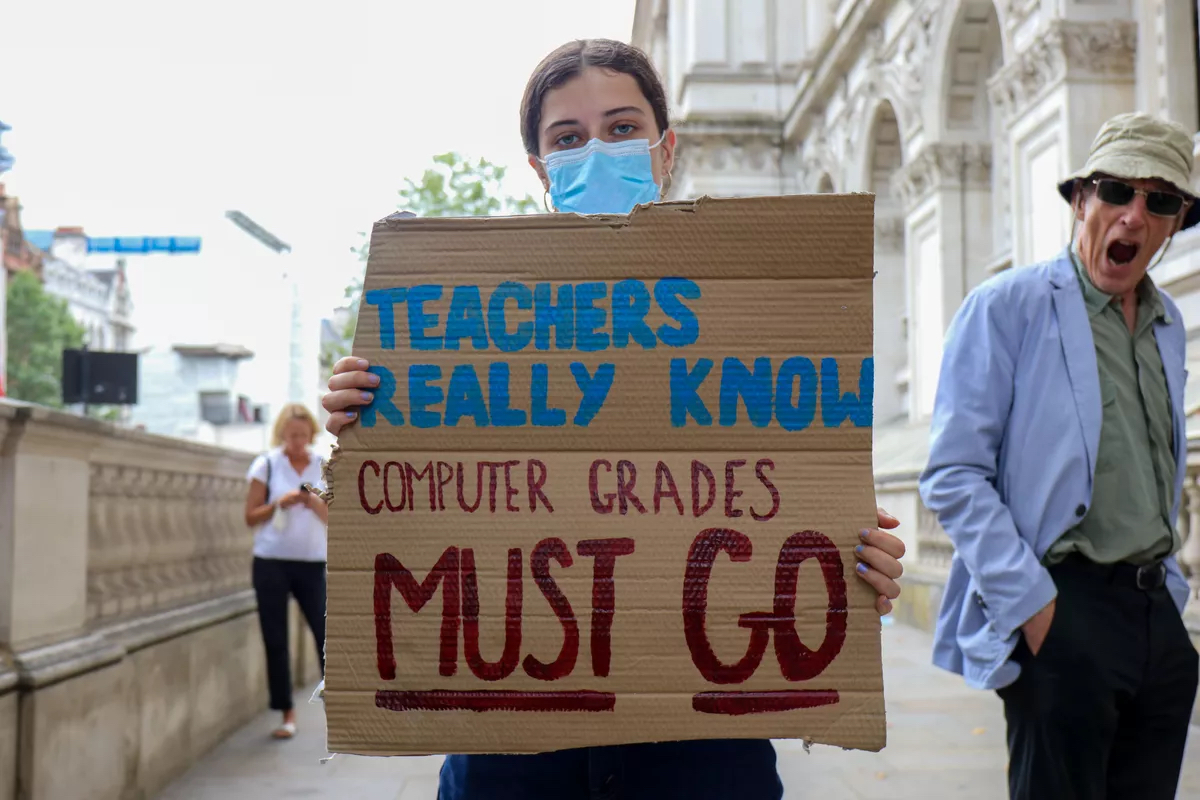

“Fuck the Algorithm”

Ese fue el canto que se escuchó en diversas ciudades del Reino Unido cuando miles de estudiantes salieron a marchar en oposición a los resultados asignados por un algoritmo creado por el Departamento de Educación con el fin de calcular la nota que estos hubieran sacado en los exámenes estatales, luego de que los mismos fueran cancelados por culpa de la pandemia del COVID-19.

En un 40% de los casos, el algoritmo asignó notas inferiores a aquellas que los profesores de esos estudiantes habían proyectado para sus estudiantes (sólo en el 2% de los casos el algoritmo asignó una nota más alta). Incluso, en la gran mayoría de los casos la nota asignada por el algoritmo fue menor a la obtenida por los estudiantes en los tests de prueba que ya habían realizado.

El algoritmo utilizó no sólo la trayectoria del estudiante y la nota que el profesor le había asignado sino que asignó variables exógenas como el barrio en el que viven, el tamaño de los salones en los que estudiaron y las notas que estudiantes del colegio obtuvieron en años anteriores en la prueba. Variables sobre las que los estudiantes tienen cero control y que en el grueso de los casos terminó generando un sesgo socio-económico que terminó afectando a aquellos estudiantes menos privilegiados.

El debate sigue creciendo pues en la medida en que más y más aspectos de nuestra vida son analizados por algoritmos y estos terminan generando recomendaciones, influenciando nuestras decisiones o tomando acciones que nos afectan directamente, se hace más clara la necesidad de entender la forma en que esos algoritmos fueron creados y entrenados y garantizar que en las mismas ha existido un proceso serio de ética y una base de entrenamiento real y no sesgada.

¿Debe una empresa que utiliza estas herramientas informarle a sus stakeholders (clientes, empleados, proveedores, estudiantes, personas interesadas en trabaja/estudiar en ella) sobre su existencia? ¿Deben los gobiernos que usan estas herramientas hacer público su uso y la forma en que fueron entrenados?

Hace ya como 3 años me pregunté: “Qué pensarán los algoritmos de mí?” en un artículo que escribí aquí en TECHcetera. Hoy me pregunto qué pensar de los algoritmos y qué hacer para que me afecten lo menos posible.