Para nadie es un secreto que la Inteligencia Artificial (IA) ha causado gran furor desde su llegada, tanto por sus múltiples beneficios como por sus “alucinaciones”, entre otros. Por tal motivo, en ocasiones se vuelve difícil entender la IA e incluso, para muchos es difícil confiar plenamente en la Inteligencia Artificial. Entonces, si fundamentalmente no comprende algo tan impredecible ¿cómo puede confiar en ella?

¿Por qué la Inteligencia Artificial Imprescindible?

Como bien sabemos, la confianza se basa en la previsibilidad. Depende de su capacidad para anticiparse al comportamiento de los demás. En este sentido, si confía en alguien y no hace lo que espera, entonces su percepción de su confiabilidad disminuye.

Muchos sistemas de Inteligencia Artificial se basan en redes neuronales de aprendizaje profundo, que de alguna forma emulan el cerebro humano. Estas redes contienen “neuronas” interconectadas con variables o “parámetros” que afectan la fuerza de las conexiones entre las neuronas. Por lo que, cuando a una red ingenua o inocente se le presentan datos de entrenamiento, “aprende” cómo clasificar los datos ajustando estos parámetros. De esta forma, el sistema de Inteligencia Artificial consigue aprender a clasificar datos que no había visto antes. No memoriza qué es cada punto de datos, sino más bien, predice cuál podría ser un punto de datos.

Muchos de los sistemas de Inteligencia Artificial más potentes contienen billones de parámetros. Por tal motivo, las razones por las que los sistemas de IA toman las decisiones que toman suelen ser opacas. Éste es el problema de la explicabilidad de la Inteligencia Artificial: la impenetrable “caja negra” de la toma de decisiones de la IA.

Hay decisiones que son difíciles de tomar para los humanos y esto es porque los mismos contamos con racionalización. Por el contrario, una IA no puede racionalizar su toma de decisiones. La IA no cumple con el requisito predictivo de confianza.

Comportamiento de la IA y expectativas humanas

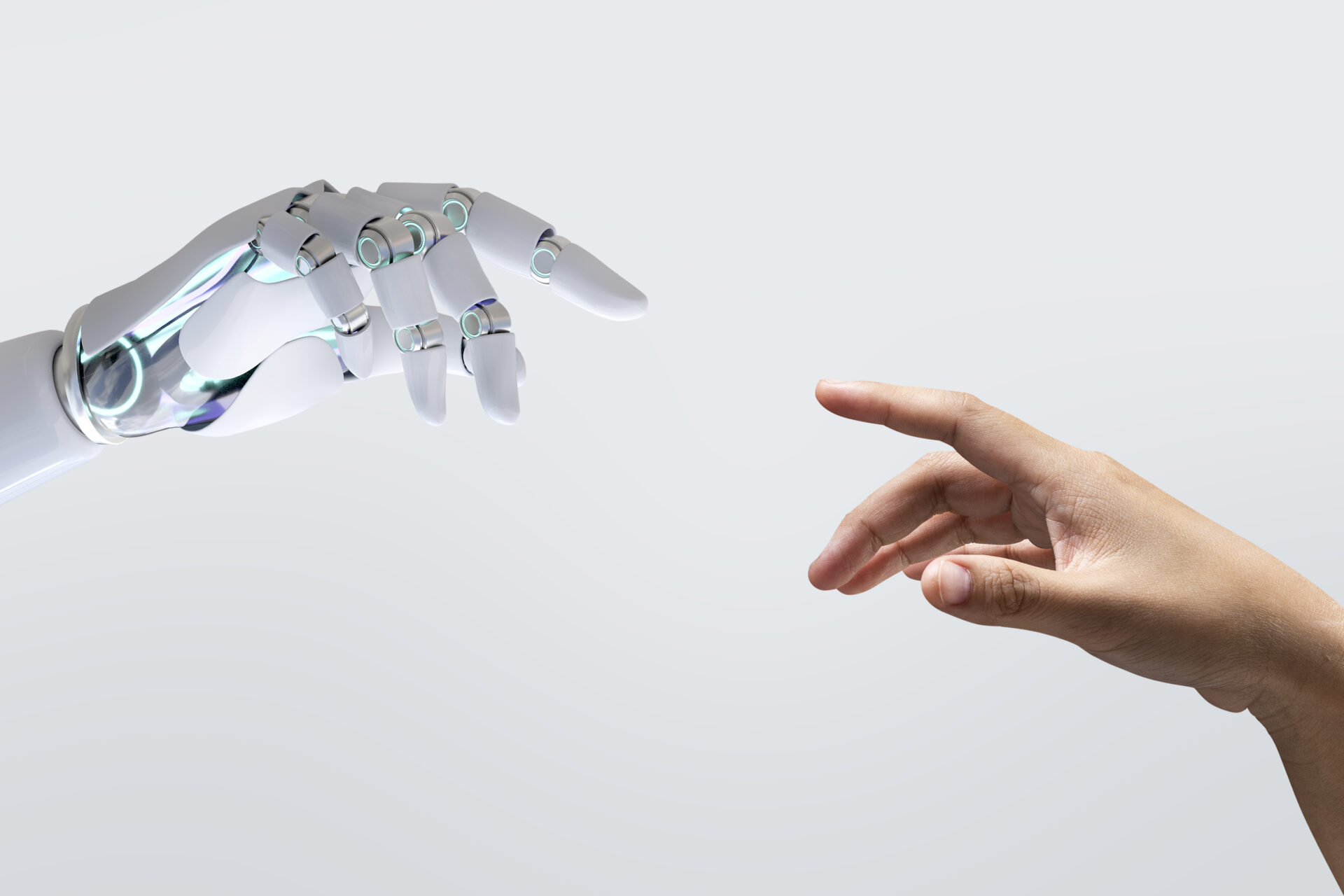

Es de aclarar que la confianza no sólo se basa en la previsibilidad sino, también, se basa en motivaciones normativas o éticas. Por lo general, espera que las personas actúen no sólo como usted supone que lo harán sino, también, como deberían. Los valores humanos se encuentran influenciados por la experiencia común y el razonamiento moral es un proceso dinámico, moldeado por estándares éticos y así mismo, percepciones de los demás.

A diferencia de los humanos, la Inteligencia Artificial (IA) no ajusta su comportamiento en función de cómo la perciben los demás ni de adherirse a normas éticas. La representación interna del mundo que tiene la IA es en gran medida estática, determinada por sus datos de entrenamiento. Por lo que su proceso de toma de decisiones se basa en un modelo inmutable del mundo, inalterable por las interacciones sociales dinámicas y matizadas que influyen continuamente en el comportamiento humano. Según se ha podido conocer, los investigadores están trabajando en programar la Inteligencia Artificial para incluir la ética, pero, es vital acotar que esto, está resultando un verdadero desafío.

Sistemas críticos e Inteligencia Artificial confiable

Una manera de disminuir la incertidumbre y aumentar la confianza viene siendo garantizar que las personas participen en las decisiones que toman los sistemas de Inteligencia Artificial. Este parece ser el enfoque adoptado por el Departamento de Defensa de Estados Unidos, el cual, exige que para toda toma de decisiones de IA, un ser humano debe estar al tanto. En el bucle quiere decir que el sistema de Inteligencia Artificial hace una recomendación pero, se requiere que un humano inicie una acción. Por su parte, “On the loop” significa que, aunque un sistema de IA puede iniciar una acción por sí solo, un monitor humano puede interrumpirla o alterarla.

Es de resaltar que aunque mantener a los seres humanos involucrados es un gran primer paso, no se tiene certeza de que esto sea sostenible a largo plazo. Conforme las empresas y los gobiernos sigan adoptando la Inteligencia Artificial, es posible que el futuro incluya sistemas de IA anidados, donde la rápida toma de decisiones limita las oportunidades de intervención de las personas. Por lo tanto, es realmente importante resolver los problemas de explicabilidad y alineación antes de que se alcance el punto crítico en el que la intervención humana se vuelva algo imposible. En ese momento, no habrá otra opción que confiar en la Inteligencia Artificial.

Evitar ese umbral es esencialmente importante porque la IA se integra cada vez más en sistemas críticos, que incluyen elementos como: redes eléctricas, así como también Internet y sistemas militares. En los sistemas críticos, la confianza es primordial y un comportamiento indeseable podría tener consecuencias mortales. Conforme la integración de la IA se vuelve más compleja, resulta aún más importante resolver los problemas que limitan la confiabilidad.

Ante todo esto ¿podrán las personas en algún momento confiar realmente en la IA? Si la confiabilidad tiene elementos inherentemente predecibles y normativos, por lo mismo, para muchos, la Inteligencia Artificial fundamentalmente no tiene muchas cualidades que la harían digna de confianza. Es de esperar que más investigaciones en esta área impulsen luz sobre este tema, garantizando de esta forma, que los sistemas de IA del futuro sean realmente dignos de nuestra confianza.