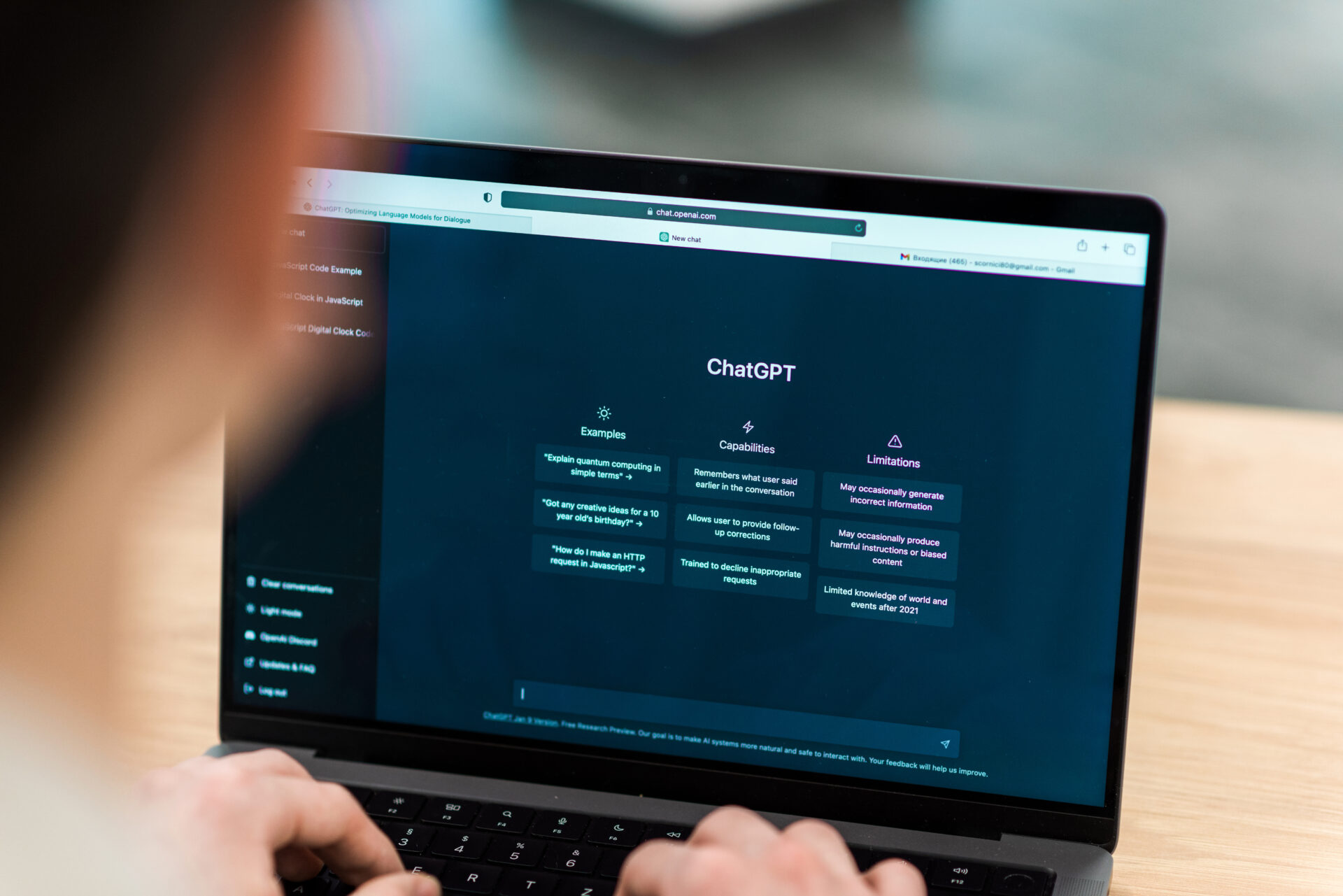

Para nadie es un secreto como ChatGPT de la reconocida compañía OpenAI, se ha convertido en una herramienta popular de rápida evolución. Pero lo cierto es que, un estudio de la Universidad de Purdue publicado recientemente ha arrojado luz sobre un elemento crítico del rendimiento que parece indicar que ChatGPT engaña a algunos de sus usuarios, lo cual, merece atención!

¿Puede ChatGPT engañar a los usuarios?

El estudio, denominado “¿Quién responde mejor? Un análisis en profundidad de ChatGPT y las respuestas de desbordamiento de pila a las preguntas de ingeniería de software”, ha profundizado en la calidad y así mismo, la usabilidad de las respuestas de ChatGPT, descubriendo algunos hallazgos intrigantes y en ocasiones problemáticos.

El equipo de Purdue logro examinar meticulosamente las respuestas de ChatGPT a 517 preguntas provenientes de Stack Overflow, una conocida plataforma de preguntas y respuestas para programadores. Tal parece que la evaluación consiguió abarcar diversos criterios, incluido algunos aspectos como: la corrección, la coherencia, así como también la exhaustividad y la concisión. Los resultados fueron esclarecedores y alarmantes.

ChatGPT de OpenAI respondió de forma incorrecta aproximadamente un 52% de las preguntas de ingeniería de software, lo que evidentemente, generó preguntas importantes sobre su precisión y así mismo, su confiabilidad como recurso de programación.

El estudio consiguió revelar incluso otro aspecto interesante del comportamiento de ChatGPT, el cual, fue la verbosidad. Un sorprendente 77% de las respuestas de ChatGPT se consideraron exorbitantemente prolijas, lo que podría afectar la claridad y también la eficiencia de sus soluciones.

Ahora bien, hay que señalar que incluso, en medio de estas inexactitudes y palabras incoherentes, sorprendentemente los usuarios siguieron prefiriendo las respuestas de ChatGPT el 39,34 % de las veces. Tal y como revela el estudio, esta preferencia se atribuye al estilo de lenguaje completo y bien articulado de ChatGPT.

Por otra parte, el estudio también destacó un rasgo distintivo del enfoque de ChatGPT, una propensión a los errores conceptuales. El modelo parece tener problemas para comprender el contexto subyacente de las preguntas, lo que lleva a una mayor frecuencia de errores.

Incluso, hay que destacar que cuando una respuesta contenía inexactitudes incuestionables, los participantes en el estudio a menudo marcaron la respuesta como preferida, lo que indica la influencia del estilo cortés y autoritario de ChatGPT de OpenAI.

Sin embargo, hay que tener presente que los autores han reconocido las limitaciones de ChatGPT, especialmente en lo que respecta al razonamiento. El modelo por lo general suministra soluciones o fragmentos de código sin comprender de forma clara sus implicaciones, lo que insinúa el desafío de incorporar el razonamiento en modelos de lenguaje como ChatGPT.

Otros aspectos resaltantes del estudio

El estudio de Purdue también consiguió profundizar en los aspectos lingüísticos y de sentimiento de las respuestas de ChatGPT. Aunque parezca sorprendente, en este caso, las respuestas del modelo exhibieron un lenguaje más formal, así como también un pensamiento analítico y sentimientos positivos en comparación con las respuestas de Stack Overflow.

Esta corriente hacia la positividad, podría estar ayudando a la confianza del usuario en las respuestas de ChatGPT, incluso, cuando el modelo contiene inexactitudes. El estudio logra enfatizar que aunque ChatGPT puede ser bastante útil, los usuarios deben ser conscientes de los riesgos potenciales relacionados con respuestas aparentemente precisas.